工作記事

八月份

01 一

- 研究 Nutch 1.2 之 IKanalyzer

- 討論 雲端資安計畫

- 需增加 icas 分析完後主動通知管理者 功能

- bug fix : crawlzilla slave_remove workspace setup error

02 二

- crawlzilla : crawlweb1 目前狀態:已增加中文分詞功能,需打包入 svn 庫

- 更新 hadoop 進階教材

- virtualbox VM 共用資料夾方法

03 三

- 研究 hadoop hdfs 與 jsp 之間的功能

- hdfs api 0.21.0 因僅0.21才有提供hdfs 的api ,其他版本皆無

- 用hadoop-core-0.20.203.jar 當函式庫編譯 hadoop-0.20.203/src/webapps/hdfs/ 的jsp 會有錯誤。需重編

- 製作 hadoop 0.20 for eclipse 3.7 plugin 下載

04 四

- java 寄信 mail javamail howto

- java 讀取 xml

05 五

- 中華電信課程

08 一

- 研究 icas 寄信功能

- 研究 icas 讀設定檔功能

09 二

- 修改 Aggregate 的 createBlacklistMail() 使之一次產生 blacklist & mail_html

- 原本是 blackListFormat 僅產生blacklist

- 改良後一次產生兩個output file 可以節省記憶體 與 io次數

10 三

- icas 可寄多個收件人

- nagios

11 四

- icas 新功能測試 = work

- nagios 安裝測試 -> ubuntu not friendly and ui is old

12 五

javadoc = http://help.eclipse.org/indigo/topic/org.eclipse.jdt.doc.isv/reference/api/

15 一

- icas 安裝於 211.73.95.39

16 二

- 將 crawlzilla 中文分詞 patch 到svn 上

17 三

請假

18 四

- 續 8/3 。重編之hadoop-0.20.203-.jar 於附件 hadoop-core-0.20.203.waue.1.jar (0821 更新 = 有bug : JsonMappingException?)

19 五

- Eclipse Indigo (3.7)

- Eclipse Helios (3.6)

- Eclipse Galileo (3.5)

- hadoop 0.20.203.0 為最新stable 版本,但其eclipse plugin 雖修正 run on hadoop 的功能,但 hdfs 設定卻有 JsonMappingException? (問題更大)

- 使用 hadoop 0.20.2 eclipse plugin 也無法搭配連接到 hadoop 0.20.203 所架設的 hadoop system (Cannot connect to the Map/Reduce? location: hadoop 。Call to pchadoop/10.0.2.15:9001 failed on local exception: java.io.EOFException )

- 結論: 要使用 eclipse 的 hadoop 開發工具開發hadoop code 還是使用 hadoop 0.20.2 版本

22 一

File > Export... > Plug-in Development > Deployable plug-ins and fragments .

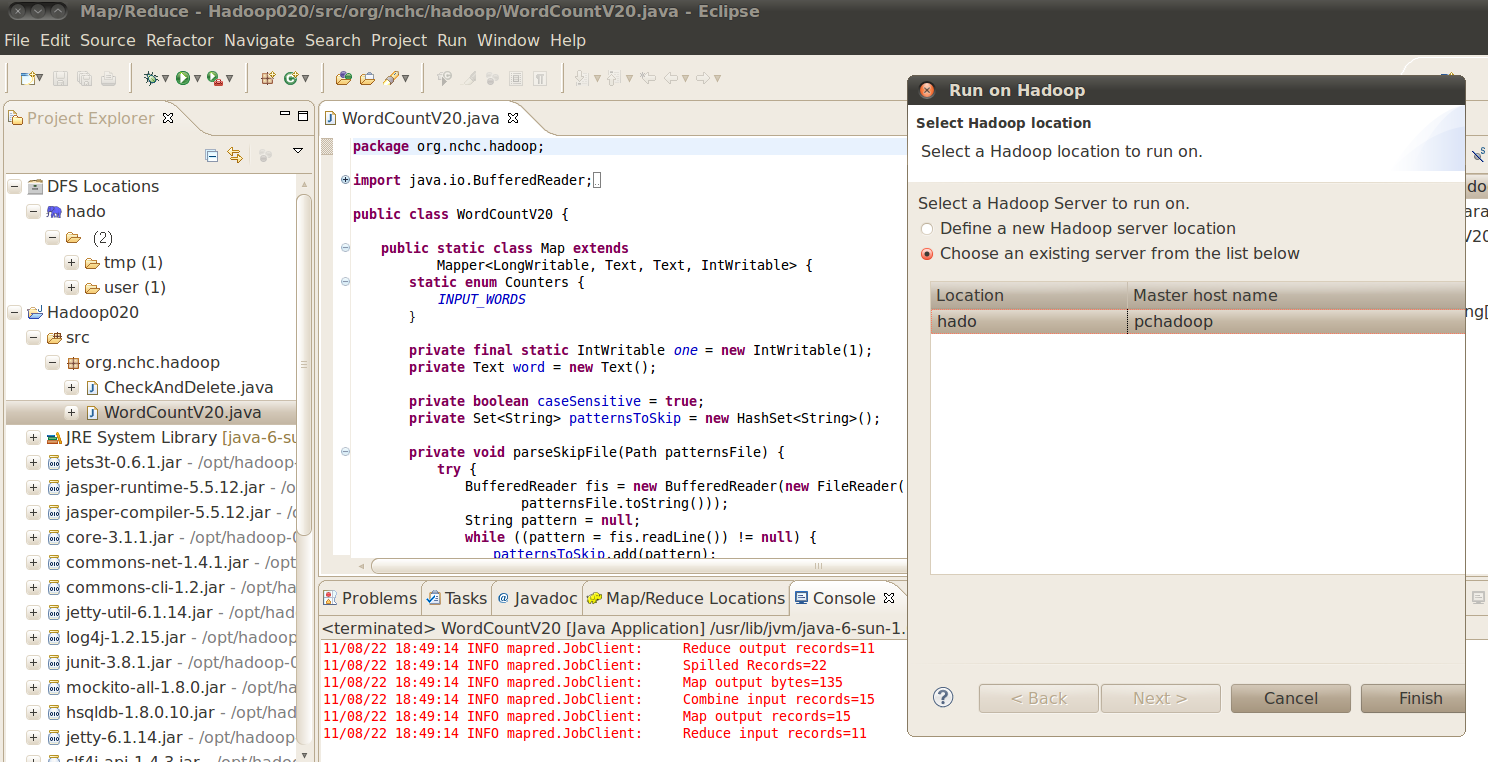

自製 hadoop 0.20.2 + eclipse 3.6 plugin status : hdfs 功能與 run on hadoop 皆正常 ; 親測可用 (已run 於 eclipse 3.6 ee 並跑 wordcount-skip v.20 於hdfs mode)

23 二

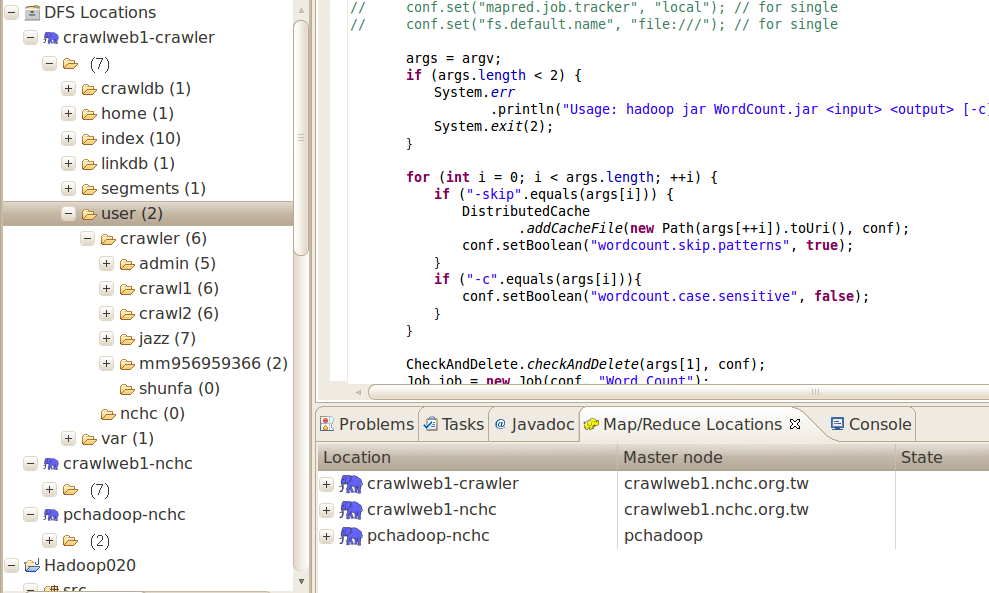

- 自製 hadoop 0.20.2 + eclipse 3.6 plugin 支援client 發job 到遠端 hadoop server 以及所有的 hdfs 操作

- 若client user 為 nchc , 則遠端 hadoop server 的 hdfs 需建立 /user/nchc 資料夾,並設定 hdfs 的 /user/nchc 權限為 nchc

- hadoop location 內的 user name 設定,將決定此連線的權限,如 設定為 nchc 則無法對遠端的 /user/crawler 內的資料夾作寫入操作

- 若出現 unknown host : XXX ,則需要將XXX 加入到 client 的 /etc/hosts 內

- 研究 spring

24 三

25 四

- 利用jquery auto refresh page contents jquery auto refresh

26 ~ 29

Spring study

30 二

Last modified 14 years ago

Last modified on Aug 30, 2011, 5:08:15 PM

Attachments (5)

- HadoopPlugin0.20-eclipse3.7.work.jar (3.4 MB) - added by waue 14 years ago.

- hadoop-core-0.20.203.waue.1.jar (3.3 MB) - added by waue 14 years ago.

- hadoopPlugin.waue.hadoop.0.20.2_eclipse.3.6.jar (2.7 MB) - added by waue 14 years ago.

- 1.png (282.2 KB) - added by waue 14 years ago.

- 2.png (143.8 KB) - added by waue 14 years ago.